⚛️ En 2026 je discute avec réseau, comment et pourquoi ?

- 12 déc. 2025

- 2 min de lecture

Passez du diagnostic manuel à l’analyse assistée par IA

Dans cette nouvelle édition nous allons aborder comment les nouvelles technologies dites conversationnelles permettent d’améliorer considérablement les coûts liés à la gestion des réseaux

L’intelligence du réseau conversationnel pour prédire, corréler, et économiser.

Les réseaux modernes génèrent des volumes massifs de données de performance, souvent dispersées et complexes à interpréter. Chaque minute passée à corréler manuellement ces mesures représente un coût opérationnel direct et un risque de retard sur la résolution d’incidents. Dans un contexte où la fiabilité et la rentabilité des infrastructures télécoms sont stratégiques, l’enjeu est désormais de transformer la donnée brute en décision immédiate et mesurable.

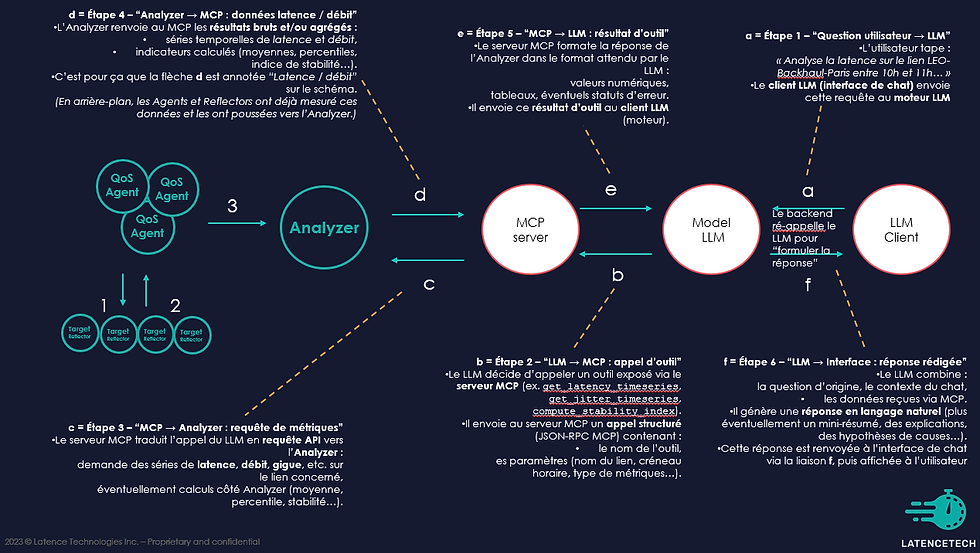

MCP, c’est quoi et comment cela fonctionne ?

Le Model Context Protocol (MCP) agit comme un traducteur intelligent entre le langage technique du réseau et les outils d’analyse. Il met en relation le modèle, le contexte et le protocole pour donner du sens aux mesures de latence, de débit ou de qualité radio.

Ce protocole crée ainsi une couche d’intelligence qui permet d’interroger et de comprendre dynamiquement le comportement du réseau, en langage naturel ou via API.

Voici 4 raisons d'implémenter l'agent AI Connect avec la plateforme Analyzer

Meilleurs rapports pour les clients donc réduction du taux de désabonnement,

Des ventes incitatives/croisées basées sur les données d'utilisation,

Réelles réductions de la charge de travail du centre d'assistance technique/des ingénieurs par ticket,

Réduction du temps moyen de résolution (MTTR) jusqu'à 70 %

Voyons un exemple concret avec Claude Code

Étape 1 – Tu ouvres le chat, tu écris dans la zone de chat :

“Analyse la latence sur le lien LEO-Backhaul-Paris entre 10h et 11h ce matin, compare avec le lien 5G-Private-Paris, et donne-moi un résumé des causes possibles.”

Le client Claude Code appelle ton serveur MCP :

get_latency_timeseries("LEO-Backhaul-Paris", 10:00, 11:00)

get_jitter_timeseries("LEO-Backhaul-Paris", 10:00, 11:00)

idem pour 5G-Private-Paris

compute_stability_index(...)

Étape 2 – Claude utilise le serveur MCP connecté à Latencetech-Analyzer

Dans la conversation, tu vois quelque chose comme :

“Je vais récupérer les séries de latence et de gigue pour les deux liens sur ce créneau, puis calculer l’indice de stabilité.”

Étape 3 – Affichage des résultats

Claude te répond dans une réponse déjà digérée :

“Entre 10:00 et 11:00 :

Lien LEO-Backhaul-Paris :

latence moyenne : 85 ms, pics à 220 ms, gigue élevée (20–30 ms).

chute de stabilité à 0,62 entre 10:32 et 10:41 (probable congestion / scheduling).

Lien 5G-Private-Paris :

latence moyenne : 18 ms, très peu de pics, gigue < 5 ms, stabilité 0,91.

Hypothèse : surcharge sur le backhaul LEO (window 10:32–10:41), la 5G reste stable → à privilégier pour trafic temps réel sur ce créneau.”

Intéressé pour un test ?

Marc Soulacroup

Commentaires